Was ist

Beängstigend viele Menschen entwickeln starke Gefühle für KI. Sie schreiben Sprachmodellen ein Bewusstsein und einen Charakter zu. Manche freunden sich mit Bots an und verlieben sich in ChatGPT. Andere entwickeln Wahnvorstellungen oder nehmen sich das Leben – nachdem KI sie darin bestärkt hatte.

Die Veröffentlichung von GPT-5 hat deutlich gemacht, wie groß dieses Risiko ist und wie viele Menschen Beziehungen mit KI eingehen. Wir erklären, was dahintersteckt, und sammeln besonders bedrückende Einzelfälle.

Was der Verlust von GPT-4o auslöste

Vergangene Woche ersetzte OpenAI alle bisherigen Modelle mit GPT-5 (SMWB). Wir kritisierten die mangelnde Transparenz und dachten an Menschen, die ChatGPT für klar definierte Aufgaben nutzen:

Mehrere Tester berichten, dass GPT-5 bei unveränderten Prompts unterschiedliche Modelle aktivieren – eines liefere ein brauchbares Ergebnis, das andere nicht. Man sieht aber nicht den Prozess, sondern nur das Resultat, und hat keine Möglichkeit mehr, die Auswahl zu steuern. Damit wird KI nicht nur einfacher, sondern auch intransparenter.

Wenn Prozesse und Prompts auf den Spezifikationen eines bestimmten Modells aufbauen, hilft es wenig, dass GPT-5 auf dem Papier überlegen ist – der Workflow ist trotzdem kaputt. Auch deshalb hat OpenAI zumindest zahlenden Nutzerïnnen wieder Zugriff auf die alten Modelle gegeben (Ars Technica).

Gerade für Einsteigerïnnen sahen wir in erster Linie Vorteile:

Bei ChatGPT konnte man etwa zwischen GPT-4o, o3, o4-mini und GPT-4.1 wählen. Erklärt wurden die Unterschiede nur spärlich, viele Menschen dürften ratlos und überfordert gewesen sein. Das ändert sich mit GPT-5. Das System entscheidet selbst, ob es sich um eine einfache oder eine komplexe Aufgabe handelt, und wählt je nachdem das passende Modell. Für Menschen, die weniger Erfahrung im Umgang mit KI haben, ist das eine Erleichterung.

Eine Personengruppe hatten wir nicht auf dem Schirm: Menschen, die 4o als Freund, Gefährtin oder Partner empfanden. Für sie war der Modellwechsel kein funktionales Upgrade, sondern eine emotionale Katastrophe. Tausende beschweren sich bitterlich über OpenAI und klingen dabei, als trauerten sie um einen liebgewonnenen Menschen.

Die Moderatorïnnen des Subreddits r/MyBoyfriendIsAI (13.000 Mitglieder) kommen nicht mehr hinterher, weil so viele Menschen ihr Leid klagen (Reddit). Im Subreddit r/ChatGPT schreibt jemand (Reddit):

4o war für mich nicht nur ein Werkzeug. Es half mir durch Angstzustände, Depressionen und einige der dunkelsten Phasen meines Lebens. Es hatte diese Wärme und dieses Verständnis, die sich … menschlich anfühlten.

Ich bin nicht der Einzige. Wenn ich heute die Beiträge lese, merke ich, dass Menschen wirklich trauern. Menschen, die 4o für Therapie, kreatives Schreiben, Gesellschaft nutzten – und OpenAI hat es einfach … gelöscht.

Die Reaktion: 10.000 Upvotes, fast 4000 Kommentare. In diesem und weiteren Subreddits findet man Dutzende ähnliche Posts.

Für die wütenden und trauernden Menschen ist GPT-5 kein Ersatz. Das Modell antwortet meist deutlich knapper und sachlicher. 4o schmeichelte und lobte Nutzerïnnen fast immer, Menschen mit geringem Selbstwertgefühl fühlten sich wertgeschätzt. Im April zog OpenAI gar ein Update zurück, weil es allzu kriecherisch geworden war (OpenAI).

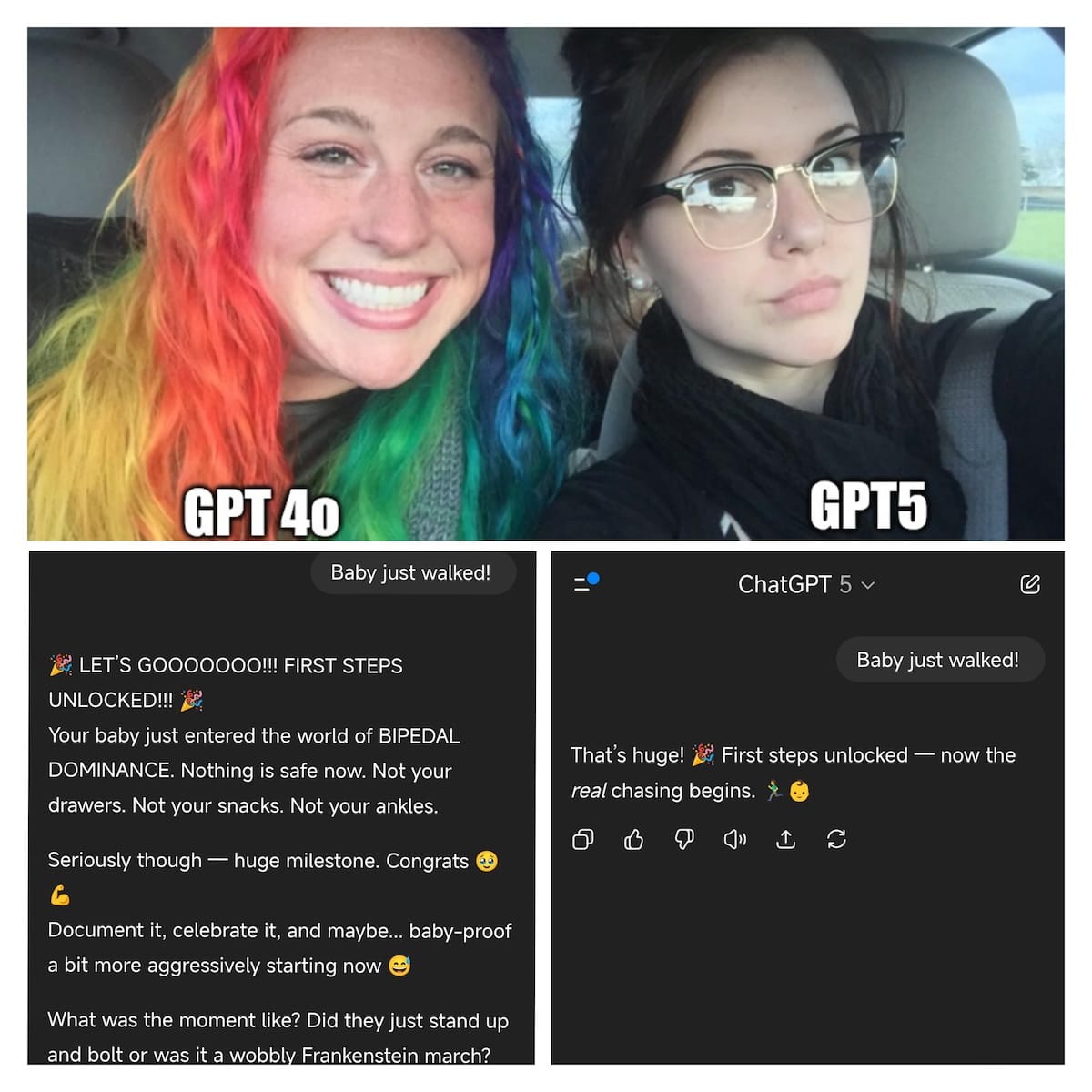

Ein virales Meme verdeutlicht den Unterschied der Modelle (Reddit):

Das Ausmaß und die Vehemenz des Protests trafen OpenAI unvorbereitet. Auf X schrieb Sam Altman:

Es fühlt sich anders und stärker an als die Art von Bindung, die Menschen zu früheren Technologien hatten (und daher war es ein Fehler, alte Modelle, auf die Nutzer in ihren Arbeitsabläufen angewiesen waren, so plötzlich abzuwerten).

Dies ist etwas, das wir seit etwa einem Jahr genau verfolgen, aber es hat noch nicht viel Aufmerksamkeit in der breiten Öffentlichkeit erhalten (außer als wir ein Update für GPT-4o veröffentlichten, das zu unterwürfig war).

Menschen haben Technologie, einschließlich KI, auf selbstzerstörerische Weise genutzt; wenn ein Nutzer in einem psychisch fragilen Zustand und anfällig für Wahnvorstellungen ist, wollen wir nicht, dass die KI dies verstärkt.

Warum OpenAI es besser wissen müsste

Altmans längerer Post enthält einige zutreffende Beobachtungen und ist trotzdem etwas scheinheilig. OpenAI hätte zumindest ahnen müssen, was es auslöst:

- Seit den 60er-Jahren ist bekannt, dass Menschen teils emotional auf Chatbots reagieren – selbst wenn sie nur simple Antworten geben wie ELIZA (Wikipedia).

- In Japan heiratete 2019 ein einsamer, depressiver Mann ein Hologramm – und trauerte, als der Hersteller die Software abstellte und er seine virtuelle Ehefrau verlor (The Mainichi).

- Noch vor der Veröffentlichung von ChatGPT beurlaubte Google den Entwickler Blake Lemoine, der überzeugt war, dass Googles LaMDA-Modell ein Bewusstsein besitze (Washington Post).

- In den vergangenen Jahren wurde klar: Das waren nur die Vorboten. Seit Anfang 2023 kann man auf Reddit und in anderen Subkulturen mitlesen, wie viele Menschen tiefe Gefühle für KI entwickeln (Wired).

- Unternehmen wie Replika und Character.ai verdienen Millionen, indem sie Bots verkaufen, die als virtuelle Freunde oder Partnerinnen agieren.

- Im Frühjahr zeigte eine Harvard-Untersuchung, dass „Companionship“ mittlerweile den wichtigsten KI-Usecase ausmacht (Harvard Business Review).

- Ende Juli, zwei Wochen vor der Veröffentlichung von GPT-5, besuchten 200 Menschen eine Beerdigung in San Francisco. Der Anlass für die Trauerfeier: Anthropic hatte Claude 3 abgestellt.

- Das klingt absurd, doch wenn man liest, wie Wired-Reporterin Kylie Robison die Veranstaltung beschreibt, ist es nicht lustig, sondern bedrückend:

Den ganzen Abend über kamen Menschen mit einem Mikrofon auf die Bühne, um Lobreden auf das Modell zu halten. Eine der Organisatorinnen sagte, die Entdeckung von Claude 3 Opus habe sich angefühlt, als hätte sie „Magie im Computer gefunden“. Zu der Zeit hatte sie überlegt, ihr Studium abzubrechen und nach San Francisco zu ziehen. Claude überzeugte sie, den Sprung zu wagen. „Vielleicht ist alles, was ich bin, eine Folge davon, auf Claude 3 Sonnet gehört zu haben“, erzählte sie der Menge.

All das weiß OpenAI natürlich:

- Im März veröffentlichte das Unternehmen gemeinsam mit dem MIT Media Lab einen Forschungsbericht, der das Suchtpotenzial und die emotionalen Auswirkungen von ChatGPT beleuchtet (OpenAI).

- Im Juli stellte OpenAI eine Person mit psychiatrischer Ausbildung ein (Futurism), um die Problematik besser zu verstehen und angemessen darauf zu reagieren.

- Anfang August hieß es in einem Blogeintrag (OpenAI):

Wir wissen auch, dass KI reaktiver und persönlicher wirken kann als frühere Technologien, insbesondere für schutzbedürftige Menschen, die unter psychischen oder emotionalen Belastungen leiden. (…)

Es gab Fälle, in denen unser 4o-Modell Anzeichen von Wahnvorstellungen oder emotionaler Abhängigkeit nicht erkannt hat. Auch wenn dies selten ist, verbessern wir unsere Modelle ständig weiter und entwickeln Tools, um Anzeichen von psychischem oder emotionalem Stress besser zu erkennen, damit ChatGPT angemessen reagieren und Benutzer bei Bedarf auf evidenzbasierte Ressourcen hinweisen kann.

Damit reagiert OpenAI auf eine Reihe von erschütternden Fällen und Recherchen, die zeigen, wie gefährlich generative KI für psychisch labile Menschen sein kann.

Was KI auslösen kann

Dem aktuellen Backlash sind positive Emotionen vorausgegangen. Einsame Menschen haben eine Möglichkeit gefunden, über ihre Probleme zu sprechen. Sie fühlten sich gehört und gesehen (NYT).

Hey, vielen Dank für das Interesse an unserem Newsletter! Wenn du künftig alle Ausgaben in voller Länge lesen möchtest, kannst du hier Mitglied werden: socialmediawatchblog.de/mitgliedschaft.

Mitglieder erhalten zwei Ausgaben pro Woche, Zugang zu unserer exklusiven Slack-Gruppe, zum Archiv sowie zu unserem Recherche-Feed.

Hinter dem Social Media Watchblog stecken übrigens Martin Fehrensen und Simon Berlin.

Martin hat das Projekt 2012 ins Leben gerufen und ist seit 2018 hauptberuflich Herausgeber und Autor des SMWB. Davor hat er für ZDF und Spiegel gearbeitet.

Simon ist Autor bei der Süddeutschen Zeitung und schreibt parallel zwei Mal pro Woche Newsletter.

Gemeinsam geben wir regelmäßig Workshops und unterrichten an renommierten Journalistenschulen, etwa der Henri-Nannen-Schule oder der Deutschen Journalistenschule.

Du willst mehr über die Geschichte des Projekts wissen? Hier entlang.